Con ejemplos concretos y reflexiones profundas, durante la presentación “Presente y futuro de la inteligencia artificial”, que tuvo lugar este miércoles 20 de noviembre, Mayr abordó el impacto de esta tecnología en industrias clave, los desafíos que enfrenta y las tendencias que marcarán su evolución en los próximos años.

Doctor en Informática por el Programa de Educación de las Ciencias Básicas (Pedeciba), Mayr cuenta con un Master en Ingeniería (por Investigación) y un Diploma de Especialización en Analítica de Big Data por la Universidad ORT Uruguay. Es, además, Ingeniero en Sistemas y trabaja como consultor independiente en IA y modelados predictivos.

Los pilares de la IA moderna

Mayr explicó que el desarrollo de la inteligencia artificial actual se basa en tres pilares fundamentales: machine learning, reinforcement learning e IA generativa.

Estas áreas están permitiendo avances disruptivos en sectores como la salud, la educación y la programación, al tiempo que transforman herramientas cotidianas.

“Por lo menos a mí, Google ya me está quedando en segundo lugar. ChatGPT lo estoy usando muchísimo”, comentó Mayr, ilustrando cómo estas tecnologías están cambiando la manera en que interactuamos con la información y resolvemos problemas.

Desafíos éticos y de seguridad

En su presentación, Mayr destacó que el avance de la IA viene acompañado de importantes desafíos éticos y de seguridad, que agrupó en tres áreas principales:

Amenazas a la privacidad

El uso masivo de datos personales para entrenar modelos plantea riesgos significativos.

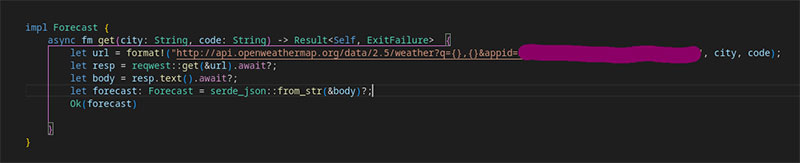

“Herramientas como Copilot han expuesto contraseñas privadas de las bases de datos de entrenamiento, revelando información sensible sin el conocimiento de los usuarios”.

Copilot es una herramienta impulsada por IA diseñada para asistir a programadores, generando automáticamente líneas de código en función de lo que el usuario escribe.

Sesgos en los datos

Los modelos de IA tienden a replicar los prejuicios presentes en los datos de entrenamiento.

Mayr mencionó el caso de los sistemas de predictive policing, herramientas que utilizan IA para predecir dónde es más probable que ocurran delitos, basándose en datos históricos.

Sin embargo, estos sistemas pueden reflejar sesgos raciales, ya que suelen asignar índices de criminalidad más altos a barrios con predominancia de ciertas etnias o características demográficas, perpetuando desigualdades existentes en lugar de mitigarlas.

El desafío de una evaluación rigurosa

Integrar IA en software exige repensar las metodologías de prueba y calidad.

Mayr destacó que los modelos de inteligencia artificial no son programados explícitamente como el software tradicional, sino que surgen de procesos de optimización basados en grandes volúmenes de datos.

Esto implica que su comportamiento no siempre es predecible, lo que puede generar fallos críticos en escenarios no contemplados durante el entrenamiento.

“El caso del auto autónomo de Uber que no reconoció a un peatón fuera de una esquina demuestra que necesitamos adaptar nuestras técnicas de evaluación a estas nuevas tecnologías”, señaló.

El modelo utilizado por el vehículo estaba diseñado para identificar peatones únicamente en intersecciones, un supuesto que no contemplaba casos como el de un peatón cruzando en el medio de la calle.

Esto, según Mayr, revela una debilidad inherente a los sistemas de IA: su capacidad para generalizar depende de los datos con los que fueron entrenados y las condiciones en las que fueron probados.

“Cuando integramos un sistema basado en IA, estamos incorporando un componente cuyo funcionamiento puede depender de variables que no controlamos del todo”.

Por esta razón, Mayr enfatizó la necesidad de repensar las estrategias de aseguramiento de calidad y verificación en el desarrollo de software.

“No basta con los métodos tradicionales de testing. Necesitamos pruebas más robustas y creativas que simulen escenarios extremos o inesperados. De lo contrario, corremos el riesgo de fallos graves en sistemas críticos, como autos autónomos o aplicaciones de salud”, advirtió.

Transformación digital 2.0

Para Mayr, la IA debe considerarse una tecnología de uso general que está redefiniendo los límites de lo que se puede sistematizar.

Citó el "Estudio de oportunidades de IA 2024 de IDC", difundido el 12 de noviembre, que estima un retorno de inversión de 3,7 veces por cada dólar invertido en IA y un aumento del 20 % en el uso de IA generativa en el último año.

“La IA es la transformación digital 2.0. Todo lo que antes parecía imposible de automatizar, ahora puede ser absorbido por esta nueva ola tecnológica”, afirmó.

https://www.youtube.com/watch?v=YnJb635f2Vk

Conocé más sobre el nuevo Master en Inteligencia Artificial